机构名称:

¥ 1.0

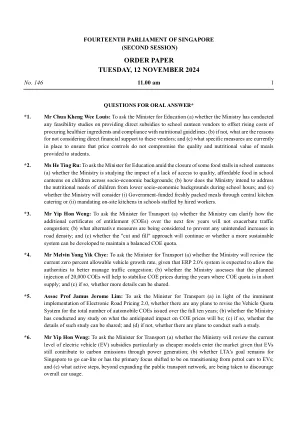

在多模态学习中,某些模态比其他模态更有影响力,而它们的缺失会对分类/分割准确性产生重大影响。为了应对这一挑战,我们提出了一种新方法,称为元学习模态加权知识蒸馏(MetaKD),该方法可以使多模态模型即使在关键模态缺失的情况下也能保持高精度。MetaKD 通过元学习过程自适应地估计每种模态的重要性权重。这些学习到的重要性权重指导成对模态加权知识蒸馏过程,允许高重要性模态将知识迁移到低重要性模态,从而即使缺少输入也能实现稳健的性能。与该领域以前的方法通常针对特定任务且需要进行重大修改不同,我们的方法旨在以最少的调整完成多项任务(例如分割和分类)。在五个流行数据集(包括三个脑肿瘤分割数据集(BraTS2018、BraTS2019 和 BraTS2020)、阿尔茨海默病神经成像计划 (ADNI) 分类数据集和 Audiovision-MNIST 分类数据集)上的实验结果表明,所提出的模型能够大幅超越比较模型。

arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日

![arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日PDF文件第1页](/bimg/c/c6f97ed4c6c81438cf3111654150ba3f92e22310.webp)

![arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日PDF文件第2页](/bimg/a/a215c2050856ba71de05776100f599292d93923c.webp)

![arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日PDF文件第3页](/bimg/2/2e245af1c08983aea75df50789c15b7111c2f132.webp)

![arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日PDF文件第4页](/bimg/5/5a1242b057f4f9978c96f78318bca8325c5df154.webp)

![arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日PDF文件第5页](/bimg/2/2b62f9d71c977aaecc411ca007da5572bd38a475.webp)

![arXiv:2405.07155v2 [cs.CV] 2024 年 11 月 12 日](/simg/a/a950b131d362b47fd5ae1cd14876a3bec7368c35.webp)

![arXiv:2405.03541v1 [cs.CV] 2024 年 5 月 6 日](/simg/b/b0062a8e5f096579d990b3b87816beedea428ebe.png)

![arXiv:2401.03854v2 [cs.CV] 2024 年 1 月 11 日](/simg/9/99ee2fcc21e346fcc3cd849481befaeab564a53e.webp)

![arXiv:2405.12085v2 [quant-ph] 2024 年 11 月 25 日](/simg/4/4f6ded12cd175110a056dda36fea62b97d7aa029.webp)

![arXiv:2405.00781v1 [quant-ph] 2024 年 5 月 1 日](/simg/2/25d638be1a088449de05b950ec143f01020521ca.webp)

![arXiv:2404.03325v2 [cs.RO] 2024 年 9 月 12 日](/simg/5/59c444c99e7e2701f7d7ca4bf915a43724400da7.webp)

![arXiv:2209.06317v3 [cs.AI] 2024 年 12 月 4 日](/simg/6/638e631b8ee0b06487fb0006a9b4e6735f567db1.png)

![arXiv:2310.01432v3 [cs.CL] 2024 年 12 月 9 日](/simg/e/e7ceb8e93071edf9a053df0cbcf1b011fa58d8b3.webp)

![arXiv:2402.01804v4 [cs.CY] 2024 年 11 月 5 日](/simg/b/b7d5cd3ab7681d18c558faf73ee99598dfbeb883.webp)

![arXiv:2502.07192v1 [cs.CV] 2025 年 2 月 11 日](/simg/d/d0976242ca6a3c04cc3b5d1594fcaee6c780e736.webp)

![arXiv:2405.07592v4 [quant-ph] 2024 年 7 月 19 日](/simg/d/d4655fd5f3f04fdd9e47ca0b0b728f7836f4a618.webp)